ในอดีต คอมพิวเตอร์ไม่ใช่เครื่องจักร แต่เป็นคน คนที่นั่งคิดคำนวณ Operation ทางคณิตศาสตร์ง่าย ๆ เร็ว ๆ แต่ซ้ำไปซ้ำมาจนเกิดเป็นพลังการประมวลผลข้อมูลขนาดใหญ่ จนเมื่อยุคสงครามโลกครั้งที่สอง Alan Turing ได้สร้างแนวคิดของ Turing Machine ที่ใช้การทำซ้ำ การตั้งโปรแกรม มาสร้างคอมพิวเตอร์เครื่องแรกที่ใช้สถาปัตยกรรมใกล้เคียงกับคอมพิวเตอร์ที่เราใช้กันอยู่ทุกวันนี้ จนสามารถถอดอัลกอริทึมการทำงานของเครื่องเข้ารหัส Enigma ได้สำเร็จ และทำให้สงครามโลกครั้งที่สองจบสิ้นลงได้เร็วกว่าเดิม ช่วยชีวิตคนได้นับล้านจากสงคราม ก่อนที่คอมพิวเตอร์จะถูกพัฒนาขึ้นมาตามลำดับ จนเกิดการปฏิวัติครั้งใหญ่ในช่วงปี 80s ที่คอมพิวเตอร์กลายมาเป็นเครื่องใช้ประจำบ้านและสำนักงาน ที่ทำให้เราสามารถพิมพ์งาน คำนวณงาน ออกแบบ ทำกราฟฟิก ทำแอนิเมชัน ส่งอีเมล ท่องอินเทอร์เน็ต เล่น Minecraft กันได้ทุกวันนี้

แต่นั่นคงไม่ใช่ประโยชน์ทั้งหมดของคอมพิวเตอร์ แม้ปัจจุบันเทคโนโลยีคอมพิวเตอร์บ้านจะพัฒนามาจนเรียกได้ว่าแทบจะทำได้ทุกอย่าง อย่างเช่นชิป M1 ที่ Apple เปิดตัวมาในสถาปัตยกรรม Apple Silicon ในปี 2019 นั้น มีพลังการประมวลผลสูงถึง 2.6 Teraflops มากกว่า CDC 6600 ซึ่งเป็นบรรพบุรุษของ Supercomputer ในช่วงปี 1964 ที่มีพลังการประมวลผลเพียงแค่ 3 Megaflops เท่านั้น โดยที่ CDC 6600 มีราคาสูงถึง 630 ล้านเหรียญ ในขณะที่ MacBook Pro M1 มีราคาแค่หนึ่งพันสองร้อยเหรียญ

หลังจากนั้นไม่นาน Apple ก็เปิดตัวชิป M1 Pro, M1 Max และตามมาด้วย M1 Ultra ตามลำดับ ซึ่งตอนนี้ M1 Ultra กลายเป็นชิปการประมวลผลแบบสถาปัตยกรรม System on Chip ที่เร็วที่สุดในโลกบนชิปเดียวไปแล้วเรียบร้อย และมี Bandwidth การส่งข้อมูลในชิปสูงสุดถึง 2.5 TB/s พร้อมกับ Transistors มากกว่าหนึ่งแสนล้านตัวบนชิปตัวเดียว

แต่นั่นก็คงไม่ใช่เหตุผลที่เราจะบอกว่า คอมพิวเตอร์บ้าน ๆ ที่เราใช้กันนั้นเพียงพอต่อการใช้งานแล้ว เพราะอย่าลืมว่าปัจจุบันข้อมูลและความซับซ้อนในการประมวลผลนั้นเติบโตขึ้นตามพลังการประมวลผลของคอมพิวเตอร์ที่เปลี่ยนไป ลองยกตัวอย่างง่าย ๆ ถ้าเราเอา Software รุ่นใหม่ ๆ ไปรันบนคอมพิวเตอร์เครื่องที่เก่าตกรุ่น เราจะพบว่า Software จะทำงานได้ช้าลง นั่นก็เพราะว่า Hardware และ Software นั้นได้รับการออกแบบมาให้ทำงานร่วมกันในระยะเวลาใดระยะเวลาหนึ่งเพียงเท่านั้น ไฟล์ของหนัง 1 เรื่องสมัยก่อนอาจจะอยู่ที่ประมาณ 2-3 GB ก็เรียกว่าหนักแล้ว แต่ปัจจุบัน ไฟล์หนังอาจจะมีขนาดมากถึง 20-30 GB ก็ได้ ซึ่งก็มีความละเอียดขึ้นแต่ก็แลกมากับพลังของคอมพิวเตอร์ที่ต้องใช้มากขึ้นด้วย

สิ่งนี้หมายความว่า Data หรือว่าปริมาณของข้อมูลที่มนุษย์เราจะต้องจัดการก็มากขึ้นตาม ทุกอย่างเป็นตัวเร่งปฏิกริยาการเกิดขึ้นของข้อมูลมหาศาล รวมไปถึงการที่โลกนี้มีอินเทอร์เน็ตก็ทำให้การแชร์ข้อมูลกันง่ายยิ่งขึ้น (เมื่อก่อนนักวิทยาศาสตร์ต้องเขียนจดหมายคุยกัน หรือเขียน Paper แซะกัน แต่สมัยนี้มี Journal ออนไลน์ต่าง ๆ มีเลข DOI ที่รวมเอาฐานข้อมูลงานวิจัยต่าง ๆ ไว้เพื่อแชร์และศึกษากันได้อย่างรวดเร็ว) ซึ่งก็เกิดจากเรามี Probe, Sensor ต่าง ๆ มากขึ้นด้วย ทำให้เรายิ่งมีข้อมูลมากขึ้น

จะเห็นว่าในหนังวิกฤติต่าง ๆ จะต้องมีการปรากฎตัวของ Supercomputer, Mainframe หรือ HPC ปรากฎอยู่เสมอ ยกตัวอย่างเช่นในหนังเรื่อง The Day After Tomorrow นักวิทยาศาสตร์ขอใช้ Mainframe ของ NOAA เพื่อมาสร้างโมเดลการเกิดพายุ, ในเรื่อง Transformers ภาคแรก นักวิทยาการรหัสลับต้องใช้ Supercomputer มาถอดรหัส Fourier Transformation เพื่อหวังเข้าใจสัญญาณจากต่างดาว, หรือในหนังเรื่อง The Martian ที่นักวิจัย JPL ต้องใช้ Supercomputer ในการคำนวณวงโคจรหาวิธีกลับบ้านให้กับ Mark Watney แล้วก็อีกหลาย ๆ เรื่องที่เราจะนึกออก นอกจากเทพีเสรีภาพโดนทุบ สะพาน Golden Gate พัง ตึกรัฐสภาโดนบึ้ม ก็จะต้องมีฉากเกี่ยวกับ Supercomputer นี่แหละ

สิ่งนี้ก็ไม่ได้เกิดขึ้นเองจากในหนังหรอก แต่มันสะท้อนภาพโลกแห่งความเป็นจริงว่ามนุษย์ต้องพึ่งพาคอมพิวเตอร์มากแค่ไหน

เมื่อ COVID-19 บอกว่าเราต้องการคอมพิวเตอร์ประสิทธิภาพสูงขนาดไหน

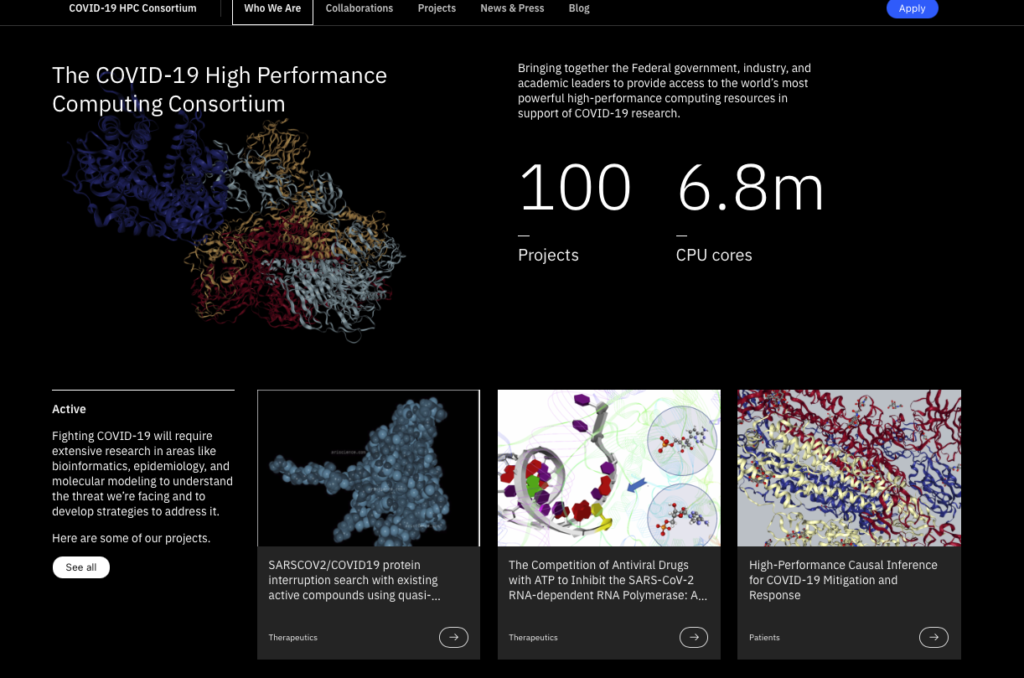

ในช่วงแรกเริ่มของการเกิดวิกฤตการ COVID-19 ที่สหรัฐฯ ได้มีการตั้งโครงการที่ชื่อว่า Supercomputer Consortium เพื่อรวมเอาพลังการประมวลผลของ Supercomputer ที่ทรงพลังที่สุดในประเทศมาช่วยกันสร้างโมเดลการระบาด และโมเดลของวัคซีน COVID-19 ซึ่งในตอนนั้นหน่วยงานที่เข้าร่วมก็มีตั้งแต่บริษัทเอกชน Google, Amazon, Microsoft, IBM, HP สถาบันการศึกษาอย่าง MIT หรือหน่วยงานรัฐบาลเช่น NSF, NASA รวมถึงสถาบันวิจัยอย่าง Lawrence Livermore National Lab เข้ามาแชร์พลังการประมวลผลในลักษณะของ Grid Computing กัน (คือการเอาคอมพิวเตอร์หลาย ๆ เครื่องมาแชร์ทรัพยากรกันผ่านอินเทอร์เน็ต)

สิ่งที่ต้องทำเช่นนี้ก็เพราะว่า ในการทำแบบจำลองการระบาดวิทยา (Epidemic, Pandemic) และการจำลองโมเลกุลของโครงสร้าง RNA และโปรตีนที่ประกอบไวรัส จำเป็นต้องอาศัยการประมวลผลสูงมาก และแน่นอนว่าต้องใช้ข้อมูลมหาศาลด้วย

“อเมริกากำลังต่อสู้กับ COVID-19 นั้นหมายถึงการปล่อย Supercomputer grid ของเราให้นักวิจัยได้ใช้เพื่อเร่งการวิจัยด้านวิทยาศาสตร์ ด้านการรักษาและด้านการพัฒนาวัคซีน” Michael Katsios, US. Chief Technology Officer ได้กล่าวไว้

ผลงานที่เด่น ๆ ของโครงการนี้ก็คือการช่วยให้ นักวิจัยสามารถสุ่มหาสารประกอบจาก Database กว่า 8,000 สารที่สามารถ bind กับโปรตีน บน envelop ของ Sars-CoV-2 ได้ เพื่อ inhibit การ bind กับเซลล์ในร่างกายมนุษย์ ทำให้เราเข้าใจพฤติกรรมของ Sars-CoV-2 นำมาซึ่งการสร้างวัคซีน (อ่าน – SARSCOV2/COVID19 protein interruption search with existing active compounds using quasi-quantum simulation)

หรือนอกจากโครงการ Supercomputer Consortium ซึ่งเป็นโครงการเสกลใหญ่แล้ว ทาง Google Cloud Platform ผู้ให้บริการ Cloud Computing รายใหญ่ของโลก ก็ยังได้ลงบทความชื่อ Road to recovery: How Google Cloud is helping states get the COVID-19 vaccine to more people เล่ากรณีการสร้าง end-to-end vaccine management distribution system ซึ่งเป็นระบบประมวลผลที่ช่วยวางแผนการฉีดวัคซีนให้กับคนมากกว่า 4 ล้านคนในมลรัฐแอริโซนา และรัฐอื่น ๆ ในสหรัฐฯ ซึ่งเป็นเบื้องหลังความสำเร็จของสหรัฐฯ ในการกระจายวัคซีนให้เข้าถึงคนให้ได้มากที่สุด ในขณะที่ก็ยังรวบรวมข้อมูลวัคซีนไว้ในที่เดียวกัน ง่ายต่อการแจกจ่ายให้ทีมวิจัยนำไปวิเคราะห์และสร้างโมเดลป้องกันการระบาดในระรอกใหม่

หลายคนอาจจะนึกภาพแค่ว่า ระบบการจองวัคซีนที่ดีคือแค่ไม่ล่มก็พอแล้ว แต่จริง ๆ แล้วไม่ใช่ เพราะการล่มหรือไม่ล่มนั่นขึ้นอยู่กับการ Optimize และ Performance แต่การจะเอาพลังของคอมพิวเตอร์มาใช้ให้เกิดประโยชน์สูงสุด คือเราต้องให้งานที่มนุษย์ไม่สามารถทำได้ เช่น การคำนวณทางคณิตศาสตร์ยาก ๆ หรือการสุ่มทำไปเรื่อย ๆ จนกว่าจะเจอสิ่งที่เราต้องการ หรือการหาคำตอบที่ใช้ทรัพยากรการประมวลผลที่ประหยัดที่สุด (นักวิทยาการคอมพิวเตอร์เรียกว่า Big-O)

สามารถดูเว็บไซต์ของโครงการ (ซึ่งภายหลังเปลี่ยนชื่อเป็น COVID-19 HPC Consortium) ได้ที่ COVID-19 HPC Consortium

นอกจากสถานการณ์ COVID-19 แล้ว Supercomputer, การทำ Grid Computing, Cloud Computing ก็ยังมีบทบาทสำคัญในงานที่เกี่ยวข้องกับความเป็นความตายของมวลมนุษยชาติ เช่น การทำโมเดลภูมิอากาศและการเปลี่ยนแปลงภูมิอากาศ (Climate Change), การวิเคราะห์เพื่อผลิตยาและวัคซีน, การทำฐานข้อมูลประชากรเพื่อจัดการระบบรัฐสวัสดิการ หรือแม้กระทั่งการค้นหามนุษย์ต่างดาวแบบในหนัง Contact (ไอเดียพ่อ Carl Sagan)

แล้วในไทยเรามี HPC, Supercomputer ไหม

ประเทศไทยของเราจริง ๆ ก็นับว่ามีระบบ HPC และ Mainframe ที่ทรงพลังอยู่หลายตัวด้วยกัน และมีโครงการที่ชื่อว่า National e-Science ของ NECTEC ที่ทำ Grid เอาไว้ด้วย เอาที่ใกล้ตัวเรามากที่สุดก็คือคอมพิวเตอร์ “CHALAWAN” ของสถาบันวิจัยดาราศาสตร์แห่งชาติ (อยู่ที่อุทยานดาราศาสตร์ฯ เชียงใหม่) ใช้ CPU 496 Core, 2.2 TB Memory พลังการประมวลผล 16 Teraflops ซึ่งในโครงการ National e-Science ก็ยังมีหน่วยงานที่นำ HPC มาร่วมอีก ได้แก่ จุฬาลงกรณ์มหาวิทยาลัย, มหาวิทยาลัยเทคโนโลยี พระจอมเกล้าธนบุรี, สถาบันวิจัยแสงซินโครตรอน, สวทช และหน่วยงานอื่น ๆ ซึ่งหนึ่งในผลงานของโครงการ National e-Science คือการเป็น Tier-2 ให้โครงการ Grid Computing ของ CERN ด้วย

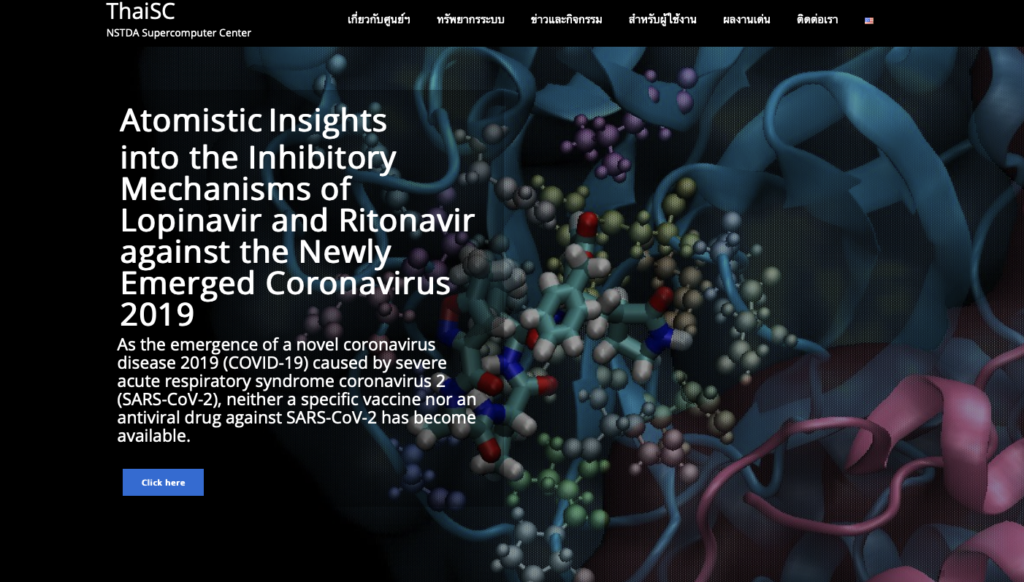

ยังมีโครงการ NSTDA Supercomputer Center ของ สวทช ซึ่งมีคอมพิวเตอร์ TARA ที่ใช้ CPU 4,320 Cores, 28 Tesla-GPUs, 3 TB++ Memory ซึ่งนับว่าเป็น Cluster ที่แรงที่สุดในไทยตอนนี้ ดูแลโดย สวทช. ภายใต้ ศูนย์ทรัพยากรคอมพิวเตอร์เพื่อการคำนวณขั้นสูง (ThaiSC) ของ NECTEC

ผลงานของ ThaiSC และ TARA เกี่ยวกับ COVID-19 ล่าสุดก็คือการทำงานวิจัย Why Are Lopinavir and Ritonavir Effective against the Newly Emerged Coronavirus 2019? Atomistic Insights into the Inhibitory Mechanisms จากจุฬาลงกรณ์มหาวิทยาลัย ที่ทำการศึกษาการผลิตยาที่ใช้ต้านไวรัส Sars-CoV-2 (ซึ่งในเว็บไซต์ของโครงการมี Paper นี้ Paper เดียวที่เกี่ยวข้องกับ COVID-19)

แล้วเราจะทำอย่างไรที่จะช่วยให้นักวิทยาศาสตร์ หรือคนทั่วไป นักเรียน นักศึกษา เข้าถึงพลังการประมวลผลมากขึ้น

พอเห็นแบบนี้แล้ว เราอยากให้ทุกคนเข้าใจว่าพลังของคอมพิวเตอร์มันเหมือนกับเป็นสมองที่อยู่ภายนอกร่างกายมนุษย์ ที่เราสามารถตั้งโปรแกรมให้มันคิดอะไรยาก ๆ แทนเราได้ แล้วเอาพลังของมนุษย์ไปใช้ให้เกิดประโยชน์กว่านี้ การที่ทุกคนสามารถเข้าถึงคอมพิวเตอร์พลังสูง ไม่ว่าจะ HPC – High Performance Computer, Mainframe, หรือ Super Computer หรือแค่ Cloud ดี ๆ ซักตัวนึงจึงเป็นเรื่องจำเป็นมาก ๆ เพราะมันจะช่วยให้มนุษย์แก้ปัญหาที่ยาก ๆ ได้

สิ่งที่เข้ามาช่วยตรงนี้มาก ๆ ก็คือการเข้ามาของ Cloud Computing หรือบริการต่าง ๆ เช่น Google Cloud Platform, Amazon AWS, Microsoft Azure, Digital Ocean ซึ่ง Platform พวกนี้เกิดขึ้นมาเพื่อแก้ปัญหาว่า สมมติเราจะทำโปรเจคซักโปรเจคที่ใช้คอมพิวเตอร์พลังสูง เราไม่จำเป็นที่จะต้องซื้อคอมพิวเตอร์แรง ๆ ไว้ที่บ้านที่อาจจะมีราคาหลายล้านบาท เราสามารถไป “ยืม” คอมพิวเตอร์ของคนที่มีอยู่แล้ว (ซึ่งหลัก ๆ ก็จะเป็นพวกบริษัทไอทีนี่แหละ เพราะต้องประมวลผล Service, Application ต่าง ๆ รวมถึงเก็บข้อมูลมหาศาลของตัวเอง) มาใช้ แล้วจ่ายราคาเฉพาะที่แค่ตัวเองใช้ โดยสิ่งที่เกิดขึ้นจะรันแบบ Application (เหมือนรันโปรแกรมโปรแกรมหนึ่ง) หรือจะรันทั้งระบบปฏิบัติการ (Virtual Machine) ก็ได้หมดแล้วแต่สะดวก แถมยังสามารถปรับ RAM, CPU, Storage ให้ตรงกับที่เราจะใช้ เหมาะสมกับงาน แถมยังสามารถปิดเมื่อไม่ใช้ หรือรันค้างไว้เป็นวันเป็นเดือนได้โดยที่ไม่ต้องห่วงว่าไฟจะไหม้บ้านหรือไฟจะดับด้วย

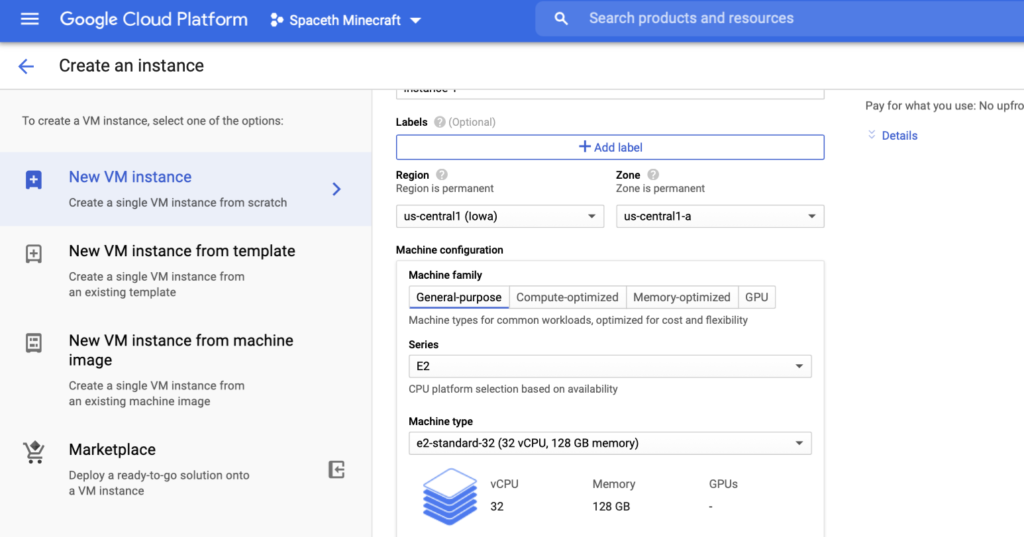

สิ่งนี้จึงทำให้การเข้าถึงทรัพยากรคอมพิวเตอร์ราคาถูกลงมาก ๆ สมมติว่าเราจะเปิด Virtual Machine บน Google Cloud Platform ให้มีเสป็คซัก CPU 32 Core, Ram 128 GB เราจะต้องจ่ายเงินเพียงเดือนละ 783 เหรียญ เพียงเท่านั้น (ไม่นับว่าถ้าไม่ใช้ก็ปิดได้อีก ตกชั่วโมงละ 1 เหรียญ หรือสามสิบกว่าบาท) ราคาถูกอย่างกับไปเล่นร้านเกม ลองนึกภาพดูว่าถ้าเราต้องซื้อคอมพิวเตอร์เสป็คประมาณนี้เอง เราอาจจะต้องใช้เงินหลายแสนบาทด้วยซ้ำ

ถ้าเราเป็น นักชีววิทยาที่ต้องทำโมเดลการแพร่ระบาดวิทยา หรือเป็นนักฟิสิกส์ที่ต้องคำนวณวงโคจรยานอวกาศ หรือเป็นนักคณิตศาสตร์ที่ต้องถอดรหัสลับที่ไขมันมานับชั่วอายุคน การที่เรามีอัลกอริทึมดี ๆ บวกกับคอมพิวเตอร์ที่ทรงพลังก็จะช่วยเป็นตัวเร่งปฏิกริยาให้เกิดงานวิจัยทางวิทยาศาสตร์ หรือแก้โจทย์ยาก ๆ ได้ง่ายขึ้น

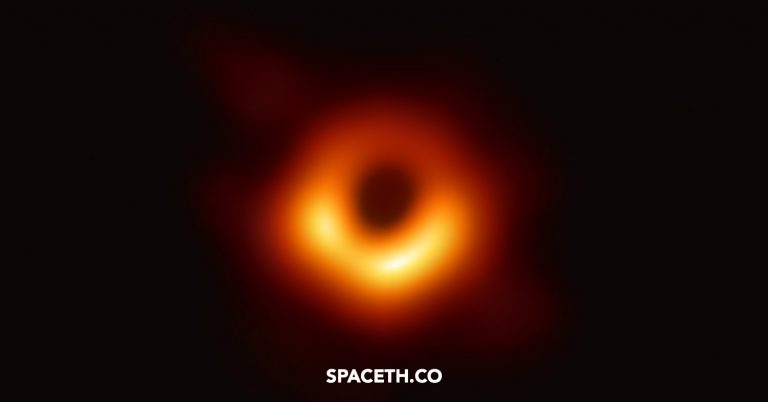

อย่างไรก็ตามทุกอย่างมีข้อดีข้อเสีย โมเดล Cloud อาจจะไม่ใช่คำตอบเสมอไป เพราะข้อจำกัดของมันก็มีเช่น ต้องวิ่งผ่านอินเทอร์เน็ต (เน็ตบ้านใครช้าก็ซวยไป), ไกลเน็ตเข้าไม่ถึง, หรือข้อมูลที่ต้องทำงานด้วยมีขนาดใหญ่มากจนไม่สามารถวิ่งผ่านอินเทอร์เน็ตได้ (ยกตัวอย่างข้อมูลจากโครงการ Event Horizon Telescope ที่เอาใส่ Harddisk ขึ้นเครื่องบินไวกว่า) แต่อย่าลืมว่าปัญหาพวกนี้มันมีทางออกทั้งนั้นเลย เช่น ปัญหาเน็ตช้า ปัจจุบันก็มีการรณรงค์กันว่าการเข้าถึงอินเทอร์เน็ตความเร็งสูงเป็นสิทธิของทุกคน หรือเน็ตไกลเข้าไม่ถึง ก็มีโครงการ Loon หรือ Starlink เพื่อช่วยให้เราสามารถเข้าถึงอินเทอร์เน็ตได้จากทุกที่บนโลก

การเข้าถึงข้อมูลดี ๆ หรือ Data ขนาดใหญ่ (มีโครงการชื่อ COVID-19 public datasets ) หรือข้อมูลพวก Open Data, การเข้าถึงอินเทอร์เน็ตความเร็วสูง, และการเข้าถึงความสามารถการประมวลผลของคอมพิวเตอร์ พร้อมกับการคิดแบบ Computational Thinking, Algorithmic Thinking, Data Driven จึงเป็นสิ่งที่จำเป็นมาก ๆ หากเราต้องการให้มีการสร้างองค์ความรู้ใหม่ ๆ หรือแก้ปัญหายาก ๆ ของมนุษย์

การผลักดันให้เยาวชน นักเรียน นักศึกษา นักวิทยาศาสตร์เข้าถึงอินเทอร์เน็ต เข้าถึงคอมพิวเตอร์แรง ๆ จึงสำคัญมาก ๆ เพราะในอนาคตเราก็จะเจอปัญหายาก ๆ อีก แถมเด็ก ๆ ยังจะต้องโตมาในโลกที่ทุกอย่างเป็นข้อมูล คอมพิวเตอร์จึงเป็นเพื่อนที่จำเป็นและจะช่วยเราไว้ในยามวิกฤติ

เรียบเรียงโดย ทีมงาน Spaceth.co